GUC

Nachweis

Programm

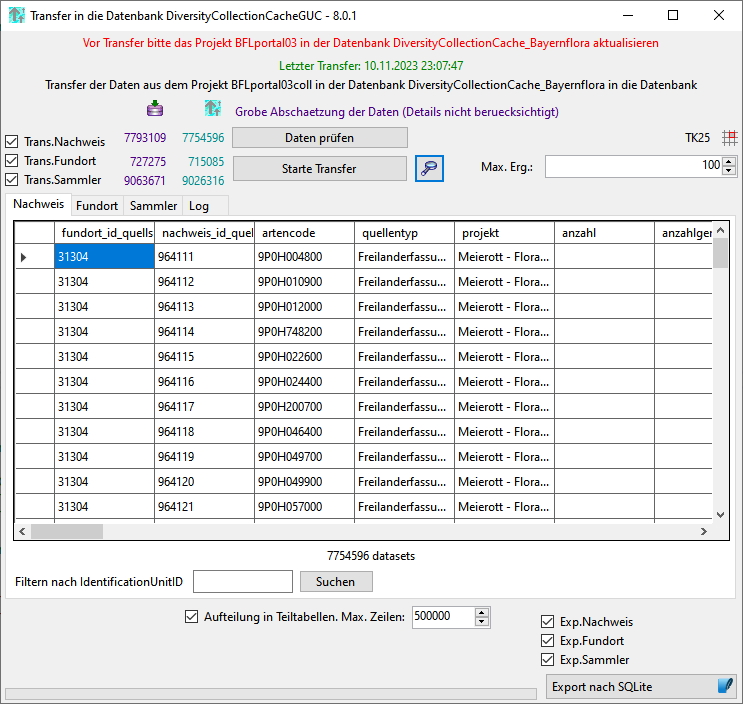

Beim Start des Programms werden die aktuellen Zahlen in den Quellen und dem Cache für die GUC geladen. In der Kopfzeile werden das Datum des letzten Transfers für das Projekt BFLportal03coll sowie die Artcodes angezeigt. Beide dienen als Grundlage für die Daten die an die GUC geliefert werden und sollten entsprechend aktuell sein.

--- title: Quellen (Server, Datenbanken) für die Daten --- graph LR; Tnt[<i class="fa-fw fas fa-server"></i> Server<br>TNT] -->DTN_Plants(<i class="fa-fw fas fa-database"></i> Database<br>DTN_Plants)-->DTN_Plants_Bfl(<i class="fa-fw fas fa-lock"></i> Projekt<br>BFLnames) Bfl[<i class="fa-fw fas fa-server"></i> Server<br>BFL] -->DC_Bfl(<i class="fa-fw fas fa-database"></i> Database<br>DC_Bayernflora)-->DC_Bfl_3(<i class="fa-fw fas fa-lock"></i> Projekt<br>BFLportal03coll) DC_Bfl_3-->DC_Bfl_Cache(<i class="fa-fw fas fa-database"></i> Database<br>DC_BayernfloraCache) DTN_Plants_Bfl-->DC_Bfl_Cache(<i class="fa-fw fas fa-database"></i> Database<br>DC_BayernfloraCache) DC_Bfl_Cache-->DC_Bfl_Guc_Cache(<i class="fa-fw fas fa-database"></i> Database<br>DC_BayernfloraGucCache)

Aktualisierung der CacheDB

Vor dem Export für GUC müssen die Daten der hierfür relevanten Projekte in der DiversityCollectionCache_BayernFlora aktualisiert werden.

Aktualisierung der Artcode Tabelle

Vor dem Export für GUC müssen die Daten in der Tabelle Artcode aktualisiert werden.

Transfer in die GUC Tabellen

Mit einem Click auf den Button wird die Prozedur TransferToGUC (s. unten) gestartet. Diese Überträgt die Daten aus der Datenbank DiversityCollectionCache_BayernFlora in Abhängigkeit der ausgewählten Optionen in die Tabellen der Datenbank DiversityCollectionCacheGUC und bereitet diese für den Export auf.

--- title: PROCEDURE TransferToGUC --- graph TD; TransferToGUC[<i class="fa-fw fas fa-arrows-rotate"></i> Hauptprozedur<br>zum Übertrag] -->Festhalten_Zeitpunkts(<i class="fa-fw fas fa-stopwatch"></i> Festhalten<br>des Zeitpunkts)-->Festhalten_Zeitpunkte(<i class="fa-fw fas fa-stopwatch"></i> Festhalten<br>des Zeitpunkts<br>aller Schritte<br>→Tabelle _Log)-->fundort_datum[<i class="fa-fw fas fa-arrow-alt-circle-down"></i> Einlesen der Daten in<br>_fundort_letzte_Aend...<br>→Tabelle _Log]-->Alle_Zeitpunkte[<i class="fa-fw fas fa-stopwatch"></i> ...<br>→Tabelle _Log] Festhalten_Zeitpunkts-->LoeschenTabellen(<i class="fa-fw fas fa-trash"></i> Löschen<br>der Tabellen:<br>_Status, <br>NACHWEIS, <br>FUNDORT, <br>SAMMLER) -->Status[<i class="fa-fw fas fa-arrow-alt-circle-down"></i> Einlesen der Daten<br>in _Status] LoeschenTabellen-->_Identification[<i class="fa-fw fas fa-table"></i> Tabelle<br>_Identification] -->Loeschen_Identification(<i class="fa-fw fas fa-trash"></i> Löschen<br>der Daten)-->Einlesen_Identification[<i class="fa-fw fas fa-arrow-alt-circle-down"></i> Einlesen<br>der Daten ]-->Loeschen_Identification_ohne_artencode(<i class="fa-fw fas fa-trash"></i> Entfernung<br>von Daten<br>die keinen<br>artencode haben) Loeschen_Identification_ohne_artencode-->Einlesen_Nachweis LoeschenTabellen-->Nachweis[<i class="fa-fw fas fa-table"></i> Tabelle<br>NACHWEIS]-->Einlesen_Nachweis[<i class="fa-fw fas fa-arrow-alt-circle-down"></i> Einlesen<br>der Daten]-->Loeschen_Nachweis_ohne_Jahr(<i class="fa-fw fas fa-trash"></i>Entfernung<br>von Daten<br>die kein<br>Jahr haben)-->Eintag_Nachweis_Status(<i class="fa-fw fas fa-pen"></i> Eintrag<br>des Status)-->Eintag_Nachweis_quellentyp(<i class="fa-fw fas fa-pen"></i> Eintrag<br>des Quellentyp)-->Eintag_Nachweis_verbleib_nachname(<i class="fa-fw fas fa-pen"></i> Eintrag<br>verbleib_nachname)-->Eintag_Nachweis_projekt(<i class="fa-fw fas fa-pen"></i> Eintrag<br>projekt)-->Eintag_Nachweis_VERORTUNG_PUNKT_WKT(<i class="fa-fw fas fa-pen"></i> Eintrag<br>VERORTUNG_PUNKT_WKT)-->Eintag_Nachweis_status_code_lfu(<i class="fa-fw fas fa-pen"></i> Eintrag<br>status_code_lfu)-->Export_Nachweis(<i class="fa-fw fas fa-download"></i>) Status-->Eintag_Nachweis_Status LoeschenTabellen-->FUNDORT[<i class="fa-fw fas fa-table"></i> Tabelle<br>FUNDORT]-->Einlesen_FUNDORT[<i class="fa-fw fas fa-arrow-alt-circle-down"></i> Einlesen<br>der Daten]-->Eintag_FUNDORT_tk(<i class="fa-fw fas fa-pen"></i> Eintrag<br>TK, Quadrant, ...)-->Eintag_FUNDORT_toponym(<i class="fa-fw fas fa-pen"></i> Eintrag<br>toponym)-->Eintag_FUNDORT_Hoehe(<i class="fa-fw fas fa-pen"></i> Eintrag<br>Hoehe)-->Eintag_FUNDORT_lebensraum(<i class="fa-fw fas fa-pen"></i> Eintrag<br>lebensraum)-->Eintag_FUNDORT_WGS84(<i class="fa-fw fas fa-pen"></i> Eintrag<br>WGS84)-->Eintag_FUNDORT_naturraum(<i class="fa-fw fas fa-pen"></i> Eintrag<br>naturraum)-->Eintag_FUNDORT_landkreis(<i class="fa-fw fas fa-pen"></i> Eintrag<br>landkreis)-->Eintag_FUNDORT_naturraum_code_lfu(<i class="fa-fw fas fa-pen"></i> Eintrag<br>naturraum_code_lfu)-->Eintag_FUNDORT_landkreis_code_lfu(<i class="fa-fw fas fa-pen"></i> Eintrag<br>landkreis_code_lfu)-->Export_Fundort(<i class="fa-fw fas fa-download"></i>) LoeschenTabellen-->SAMMLER[<i class="fa-fw fas fa-table"></i> Tabelle<br>SAMMLER]-->Einlesen_SAMMLER[<i class="fa-fw fas fa-arrow-alt-circle-down"></i> Einlesen<br>der Daten]-->Export_Sammler(<i class="fa-fw fas fa-download"></i>)

Der Zeitbedarf sowie die Zahl der betroffenen Datensätze wird im Log angezeigt

Export nach SQLite

Um die Daten als SQLite zu exportieren einfach auf den Export nach SQLite